Blender wysokoobrotowy / próżniowy – rewolucja w kuchni

W dzisiejszych czasach, gdy zdrowy styl życia i szybkie tempo życia idą w parze, blender wysokoobrotowy i blender próżniowy stają się nieodłącznym elementem nowoczesnej...

Bawełna organiczna: świadomy wybór dla mody i planety

Czym jest bawełna organiczna i dlaczego warto ją wybrać?

Bawełna organiczna to materiał pozyskiwany z roślin bawełny, których uprawa przebiega zgodnie z restrykcyjnymi normami ekologicznymi....

Suzuki Alto: Kompaktowy Mistrz Miejskiej Dżungli

Suzuki Alto to model, który od lat cieszy się uznaniem kierowców szukających ekonomicznego, zwrotnego i praktycznego samochodu do codziennego użytku, szczególnie w warunkach miejskich....

Kanały stanu: Fundament komunikacji w systemach rozproszonych

Kanały stanu, choć nie zawsze oczywiste dla przeciętnego użytkownika technologii, stanowią kluczowy element wielu zaawansowanych systemów informatycznych. W świecie, gdzie dane przemieszczają się błyskawicznie...

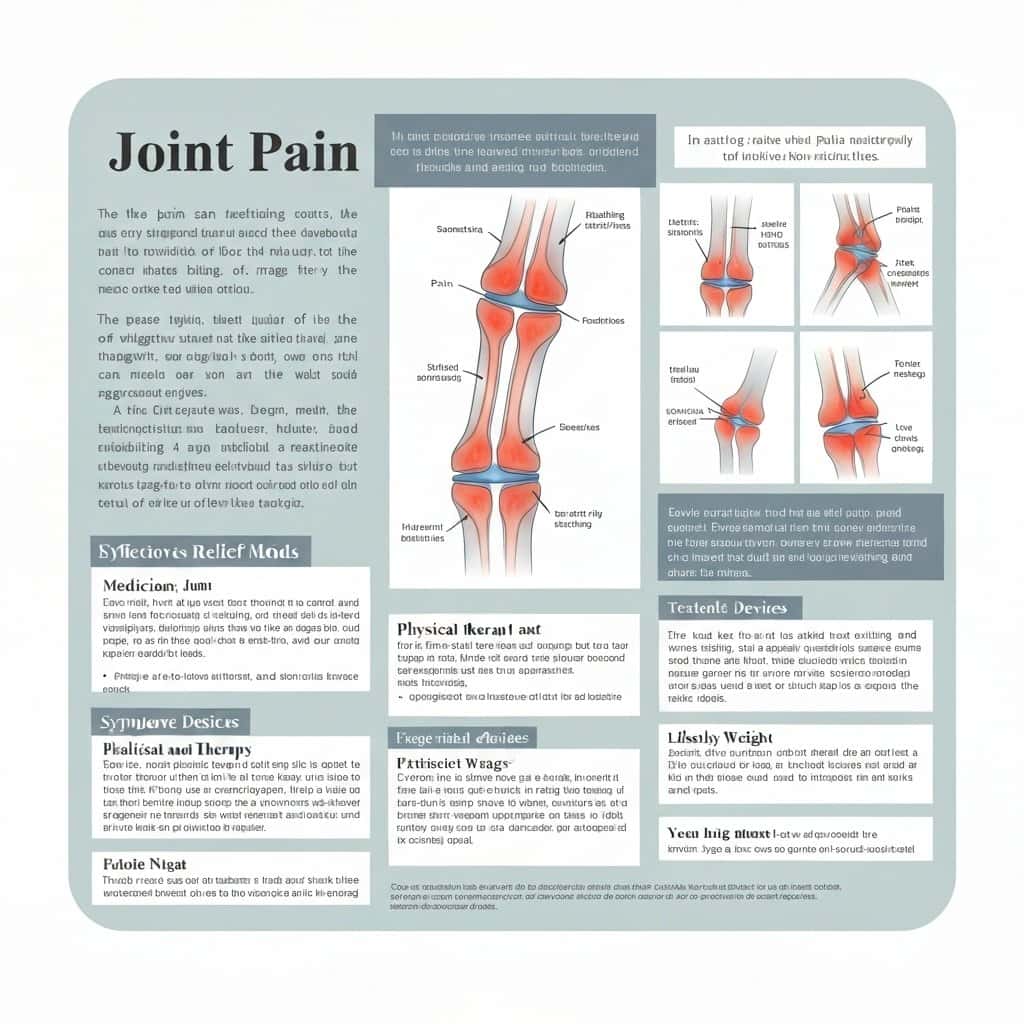

bóle stawów: przyczyny, objawy i skuteczne metody łagodzenia

bóle stawów to powszechna dolegliwość, która może znacząco wpływać na jakość życia. Dotykają one osób w różnym wieku i mogą mieć wiele przyczyn. Zrozumienie...

Liberalizacja prawa aborcyjnego: projekt w Sejmie – co dalej?

Debata nad prawem do przerywania ciąży w Polsce nabiera tempa, a projekt ustawy liberalizującej przepisy aborcyjne trafił do Sejmu. Jest to krok, który budzi...

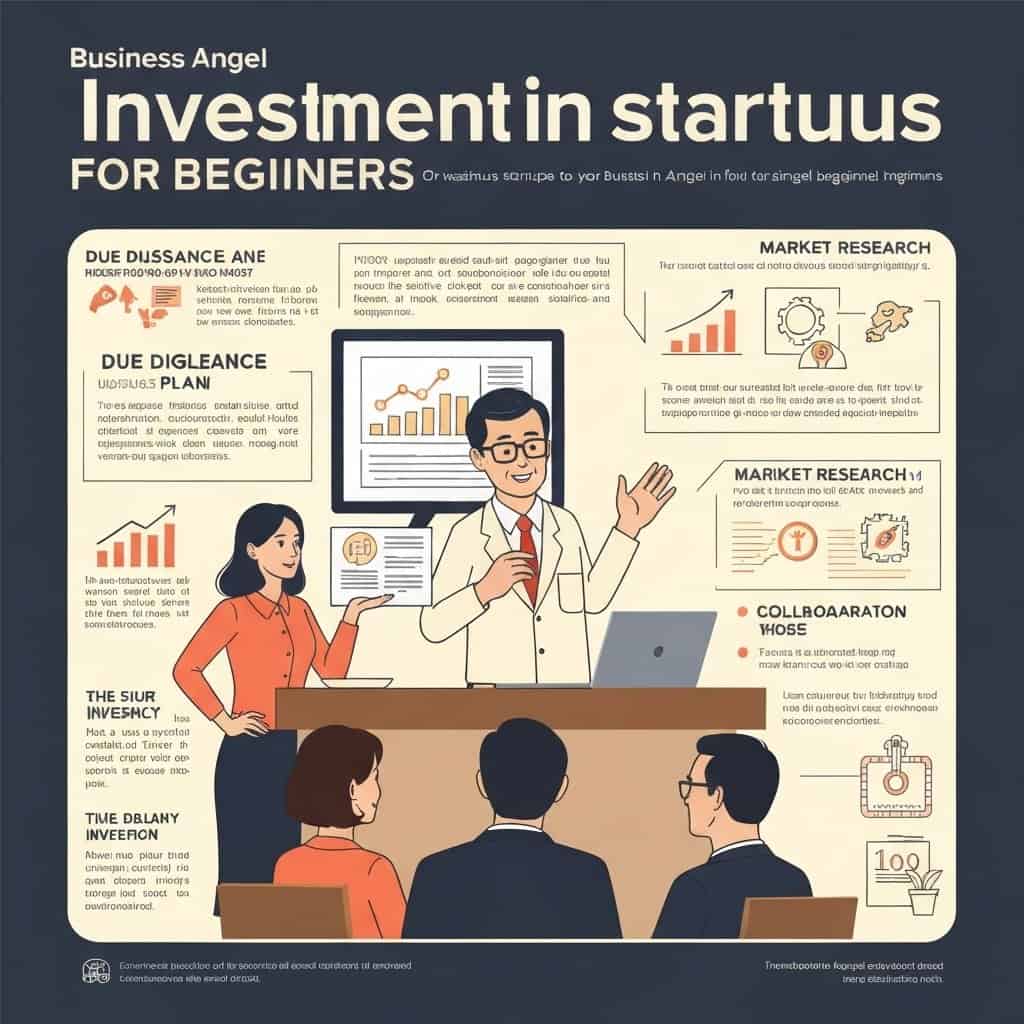

Inwestowanie w startupy – anioł biznesu dla początkujących

Kim jest anioł biznesu i dlaczego warto nim zostać?

Anioł biznesu, znany również jako inwestor prywatny, to osoba fizyczna, która inwestuje własne środki finansowe w...

Jak przyspieszyć kompostowanie? Sekrety szybkiego tworzenia cennego nawozu

Kompostowanie to ekologiczny sposób na zagospodarowanie odpadów organicznych z kuchni i ogrodu, przekształcając je w wartościowy nawóz. Choć proces ten może wydawać się powolny,...

Ikoniczne momenty w historii pokazów mody, które zmieniły oblicze branży

Pokazy mody to nie tylko prezentacja najnowszych kolekcji, ale przede wszystkim spektakl, który potrafi wywołać emocje, zainspirować i na stałe zapisać się w historii....

Kamera inspekcyjna: Niezbędne narzędzie w warsztacie i nie tylko

Co to jest kamera inspekcyjna i jak działa?

Kamera inspekcyjna, znana również jako endoskop lub kamera wężowa, to zaawansowane urządzenie służące do oglądania trudno dostępnych...